L’interattività come gioco accomuna molti artisti e performer. Da Myron Kruger che coniò il termine Realtà artificiale e che creò i primi ambienti interattivi in cui lo spettatore con la sua ombra grazie a telecamere, veniva proiettato all’interno di uno schermo dove era rappresentato un mondo fatto di grafiche colorate con cui interagiva (da Videoplace a Glowflow a Metaplay) agli italiani GMM con le varianti da Buddah vision per Mandala system (un sistema di proto realtà virtuale inventato negli anni Ottanta dai canadesi Vivid Group); e ancora da Reactable di Sergi Jordà, tavolo sonoro con touch screen su cui vengono appoggiati oggetti generatori di pattern sonori, all’interactive carpet del TPO di Davide Venturini, sfondo colorato calpestabile per spettacoli per ragazzi. E arriviamo ai più raffinati programmi di interaction design (vedi E-motions di Adrien Mondot per coreografie digitali -vedi Cinématique-) e di augmented reality (come i videomapping interattivi di Klaus Obermaier o del gruppo 1024architecture) che non eliminano affatto la dimensione del gioco collettivo. Anzi, anzi la “aumentano”.

Orf Quarenghi programmatore in Visual C++, docente alla Naba di Milano, è l’autore dei sistemi interattivi del gruppo multimediale N03 con cui ha dato vita al Museo della Resistenza di Fosdinovo (realizzato nel 2000 con Studio Azzurro, uno dei primi musei interattivi italiani, con i volti, le parole, i luoghi, le testimonianze della resistenza tra la Liguria e la Toscana), al Museo diffuso della Resistenza di Torino, agli allestimenti per il bicentenario verdiano (Museo della Scala) e per la Pirelli (Triennale di Milano). E ancora, la toccante mostra su Luciana Nissim A noi fu dato in sorte questo tempo, presso la baracca recuperata ex Campo Fossoli a Carpi (Modena). Nel campo performativo crea i visual live per concerti con il gruppo LLOQ Project.

Ma forse non tutti sanno che Orf Quarenghi ha collaborato anche alla creazione delle videoscenografie sincronizzate e ai sistemi per le coreografie digitali e spettacoli interattivi a firma di Studio azzurro (1997, The Cenci; 1998: Il fuoco, l’acqua e l’ombra, ispirato a Andrei Tarkovskij; 1998 Giacomo mio salviamoci! Con Umberto Orsini; 1998, Wer möchte Wohl Kaspar Hauser sein?). Si tratta delle prime esperienze italiane di ambienti sensibili dedicati espressamente al teatro che il compianto Paolo Rosa così amava descrivere: “Una vera e propria area laboratoriale antropologica permanente, in grado di utilizzare gli strumenti e linguaggi più nuovi, come spesso il teatro ha fatto nella sua lunga e impressionante storia, e capace di produrre anticorpi di consapevolezza e di creatività partecipata”.

Progetto a sua firma unica invece, questo “protoTypo” che dal nome denuncia tutto l’amore del suo autore per le invenzioni industriali: uno spray-gun (l’interattore) esattamente come quello usato per le pitturazioni da carrozziere, in mano a divertiti spettatori, soffia aria e colore virtuali che interagiscono (grazie a raggi infrarossi) con uno schermo dove valanghe di lettere vanno a comporre o scomporre parole e pensieri in libertà. Una specie di gioco surrealista di scrittura che molto sarebbe piaciuto a Tristan Tzara o a André Breton. Una giocosa ars combinatoria di lettere e di frasi che inaspettatamente si srotolano ma solo se l’oggetto disegnato viene completamente liberato –grazie allo spray-gun- dalla nuvola di fonemi, consonanti e aggregati di dittonghi che lo ricopre. Un’applicazione ludica che potrebbe creare interessanti sfondi live e interattivi per performance poetiche. Rimane con lo spray interattivo, la memoria sia del grafo (a spruzzo) della pittura industriale sia del gesto pittorico dello stencil, riportandoci a una forma (evoluta digitalmente) di urban art. Basta premere il grilletto….

ProtoTypo visto a Frontiers of interaction alla Fiera di Milano lo definisce un “contenitore di storie” e lo ha applicato a installazioni artistiche. Come funziona e da dove è partito come concept?

<<Il concept è nato dall’interattore: la pistola a spruzzo da carrozziere. Usavo questa pistola vent’anni fa per farmi le T-shirt con gli stencil. E’ un oggetto che in mano mi ha sempre dato una gran bella sensazione e mi dispiaceva che rimanesse in cantina a far polvere. Così ho cominciato a chiedermi come usarla in un contesto interattivo. Devo aggiungere che negli ultimi tempi le mie modalità di lavoro hanno subito un cambiamento abbastanza repentino. La crisi ha colpito duro l’ambito culturale e museale, e procacciarsi lavoro è diventato molto più difficile. Per reagire ho deciso di inventarmi un’installazione nuova, senza che nessuno me la commissionasse. Qualcosa che costasse poco, non richiedesse scenografie impegnative e che potesse essere declinato in ambito culturale, artistico e commerciale. Ho costruito protoTypo attorno alla mia convinzione -molto naïf e “da tecnico” quale io sono- che lo storytelling sia un bisogno fondamentale, e che l’interazione non sia altro che un modo di raccontare storie. La spray-gun si incastrava bene con tutto questo. Il funzionamento è basato sull’utilizzo di luce infrarossa. Ho modificato la pistola a spruzzo in modo che spruzzasse luce infrarossa anziché vernice. Tramite una telecamera customizzata e un’applicazione che ho sviluppato ad hoc, il sistema è in grado di rilevare le coordinate dove punta la pistola, e da lì in poi “è come lavorare con un mouse>>

Entrando nel merito strettamente tecnico, che strumentazione viene usata?

<<Come hardware protoTypo usa un set minimale:

– telecamera IR

– proiettore

– telo da retroproiezione

Sull’interattore (paintgun) è montato un led IR (infrarossi) a raggi infrarossi che viene acceso premendo il grilletto. L’interazione è su base ottica – immagina di proiettare un “bollo” di luce sullo schermo. Il sistema riconosce lo stato on/off del led la sua posizione sullo schermo. Siccome si utilizza luce infrarossa, nulla di tutto questo risulta visibile a un essere umano. In termini di software protoTypo è basato sull’architettura Piccolo Popolo (http://www.orfware.com/piccolo-popolo-architecture/) che ho cominciato a sviluppare ai tempi della NABA (Nuova Accademia di Belle Arti di Milano). E’ un’architettura modulare in cui ogni applicazione assolve un compito preciso e comunica con le altre mediante il protocollo OpenSound Control (OSC). Le applicazioni che costituiscono ProtoTypo sono tre:

– Mocolo: analisi in tempo reale dello stream video (telecamera a infrarossi). E’ un progetto che sto portando avanti dal 2001 e che continuo a tenere aggiornato.

– Polipo: player videografico interattivo. E’ una sorta di videogioco DirectX che integra player e mixer video che può essere configurato e comandato in remoto.

– Torsolo: master di sistema che coordina il lavoro delle altre applicazioni e implementa lo storyboard (risposta alle interazioni, gestione temporizzazioni eccetera).

I nomi sono intenzionalmente ridicoli. In passato ho lavorato con gente che battezzava software brutti e malfunzionanti con nomi altisonanti. Io ho deciso di fare l’esatto contrario!>>

In cosa l’interattività, a suo avviso, cambia il senso dell’opera d’arte?

<<Per me l’interazione è soprattutto un bel gioco. Il gesto d’interazione deve essere soddisfacente di per sè. Se si riesce a coniugare in modo sensato un “bel gesto” con un evento visuale bello e ricco di significato, allora l’interazione diventa un efficace strumento di narrazione che si può decidere di usare in contesti diversi. L’interazione cambia la modalità di fruizione, aggiunge gradi di libertà, ma non cambia il senso profondo di un’opera, che è sempre quello di raccontare una storia.>>

Questo Prototype mi ha ricordato da un lato Myron Kruger per la giocosità e l’interattività poco invasiva e dall’altro altri progetti più attuali di interaction design come Cinematique. A cosa si è ispirato, ci sono modalità o forme di interactive art che privilegia?

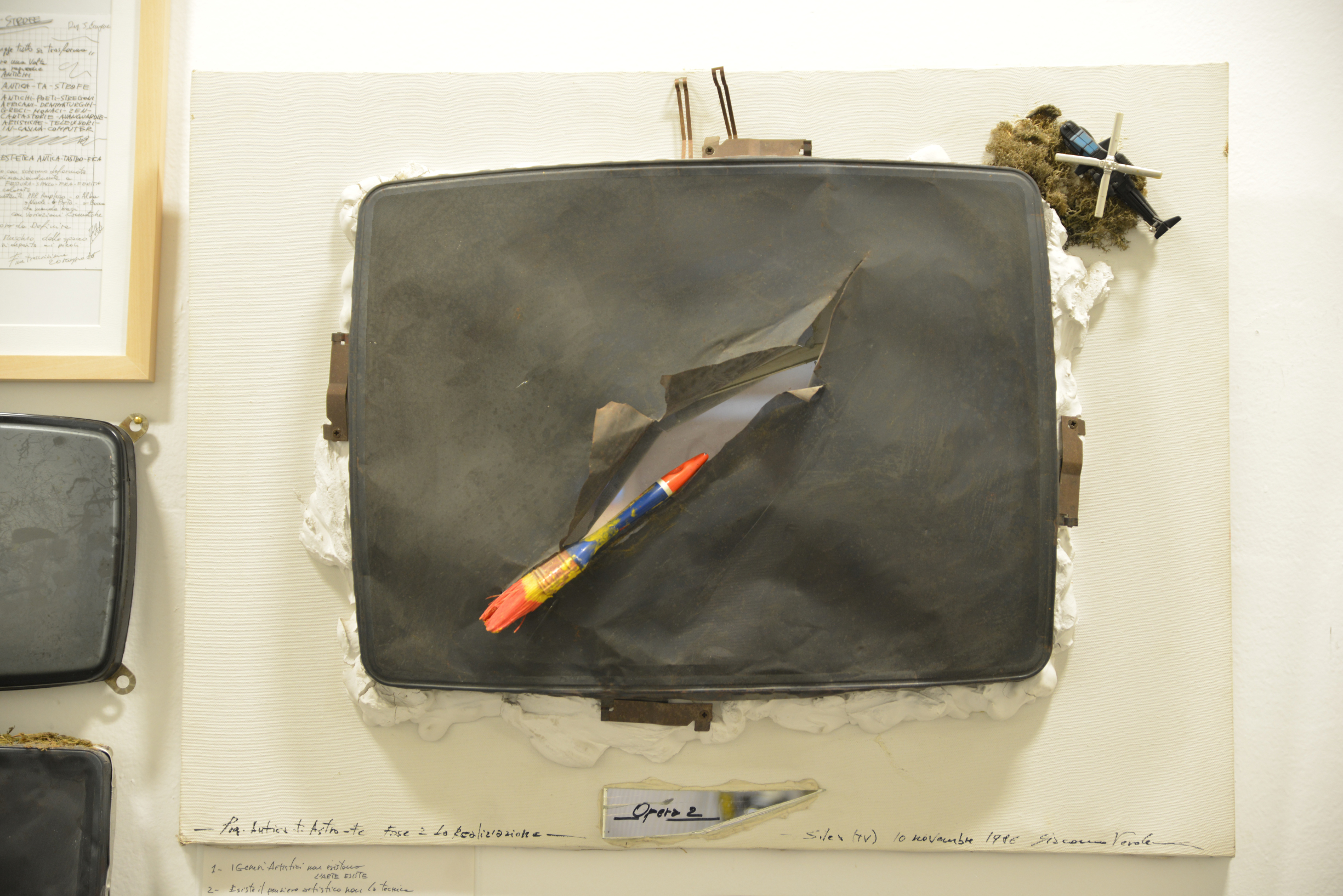

<<In realtà a me piace moltissimo usare degli oggetti, per interagire. Non è un approccio molto di moda – Kinect di Microsoft va per la maggiore, ma anche se lo trovo un oggetto tecnologico meraviglioso non mi ha ancora fatto venire idee stimolanti. Amo le sale di controllo delle vecchie stazioni ferroviarie, piene di leve, di pomelli e di enormi manometri. Mi piacerebbe moltissimo coniugare interattività e archeologia industriale, prima o poi. Rifare in scala più grande quello che ho fatto con la pistola a spruzzo, tornando a dare vita – per esempio – a una sala di comando di una vecchia centrale elettrica.>>

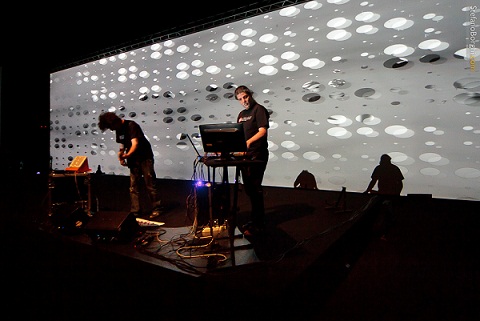

Oggi le performance usano molto spesso live media, e sistemi anche complessi di videomapping live, a tuo avviso quali sono i programmi e le soluzioni più intriganti e più flessibili da usare nel live di concerti o di reading e quali lei ha usato con il gruppo LLOQ (Luca Lomboni-Orf Quarenghi)?

<<Ho sempre utilizzato software scritto da me. Questo è sia un limite che un grado di libertà in più. Costruendo una cosa dal nulla realizzi una tua idea in grande libertà. Utilizzando software off-shelf molto diffusi il rischio è di cadere nel “tranello del plugin”: usare un certo effetto perché è “appena uscito” e trovarsi sostanzialmente a seguire una moda. Certo svilupparsi tutto in casa è faticoso e comporta tempi di lavorazione non esattamente agili…Quanto a LLOQ è nato da due vecchissimi amici che mille anni fa hanno fondato una Beasty Boys tribute band (io cantavo!). Luca era già un bassista affermato, io un enorme scalzacane..Dopo una ventina d’anni ci siamo rincontrati e avevamo ancora voglia di fare qualcosa insieme. Abbiamo buttato le nostre esperienze sul tavolo e abbiamo visto che c’erano strade da seguire, idee da far crescere, sia sul fronte tecnico che creativo.>>

Il video come interagisce in pratica, con la musica e come viene progettato l’ambiente interattivo?

<<Intercetto due tipi di informazioni dalla musica che Luca Lomboni suona dal video: la parte ritmica (segnali midi) e lo spettro acustico (campionato in tempo reale da una mia applicazione che si chiama Spatolo). I due stream di informazione vengono utilizzati per deformare interattivamente delle entità grafiche. Poi utilizzo dei mixer midi e delle pulsantiere per modificare parametri ed innescare eventi in tempo reale. Ma la base dell’interazione è sempre la musica che Luca Lomboni suona in ogni dato momento.>>

Rispetto all’audience, quanto viene recepito del processo creativo e dell’azione interattiva?

<<Credo che dell’azione interattiva venga percepito poco, temo. Dobbiamo ancora lavorarci molto, anche se sono soddisfatto dei risultati raccolti fin qui. La gente vede “succedere cose” che vanno a tempo con la musica e spesso crede che sia Luca che insegue i tempi di un clip video (approccio tecnico effettivamente utilizzato in molte performance di “interattività al contrario”…).>>

Ha lavorato ai primi spettacoli di teatro interattivo di Studio azzurro, chi e come veniva deciso l’approccio interattivo usare?

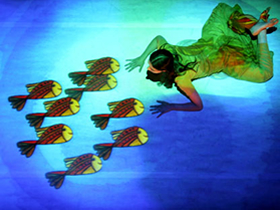

<<L’approccio – che è stato tipico nei lavori che ho realizzato per lo Studio Azzurro – era quello di creare un’entità fatta di audio e video che avesse dei comportamenti, che in qualche modo interagisse con pubblico e performer. Erano gli anni della “non linearità”, e per implementare quel comportamento ho scritto un’applicazione che si chiamava “Eschilo” e consentiva di gestire fino a 12 timeline audio/video interattive. Le timeline potevano venire collegate mediante “blocchi interattivi”. Dando il cue a uno di questi blocchi (con un colpo di mouse) si mettevano in play sincrono tutte le tracce legate a quel blocco. C’erano momenti in cui tutte le tracce (al massimo ne abbiamo usate otto) procedevano sincrone, ma con questo meccanismo era semplice uscire da una sincronia rigida, sincronizzare solo temporaneamente alcune tracce e lasciarne libere altre. Una delle cose che questa architettura consentiva di fare era definire dei cue molto fini. Ad esempio ne Il fuoco, l’Acqua, l’Ombra c’erano una serie di oggetti che apparivano sul pavimento che venivano calpestati da una performer e poi sparivano. Non era “interazione al contrario” (cioè: la performer che impara a memoria i tempi di un video). Il performer agiva con i suoi tempi e l’operatore di Eschilo sganciava il blocco giusto al momento giusto. L’operatore Eschilo era un po’ regista e un po’ performer. Eschilo è figlio mio, ma è nato anche e soprattutto grazie alle molte birre bevute con Davide Sgalippa (Studio Azzurro, N03) e alle molte notti insonni trascorse “sul pezzo”. Regista lui, sviluppatore io. Si lavorava cercando e costruendo un linguaggio comune.>>

Come si lavora con i performer o i danzatori usando sistemi interattivi e che problematiche implica?

<<E’ complicato. Io ho sempre fatto del mio meglio per fare in modo che il software consentisse di andare incontro alle esigenze delle prove, ad esempio “ripartire da un certo punto”. A volte le attrezzature tecniche pilotate dal software però, non lo consentivano (stiamo parlando dei mitici Laserdisk Pioneer!)>>

N!03 nasce da una collaborazione comune e con un legame con Studio azzurro e lei ha avuto un lungo rapporto di lavoro con il gruppo milanese. Paolo Rosa ha lasciato un segno indelebile nei territori d’arte tecnologica e non solo: cosa si sente di dire che le ha lasciato in eredità un artista come Paolo?

<<Quello con Paolo è stato un dialogo intenso e difficile. Non so se si può parlare di eredità. Mi rimane di quegli anni il linguaggio comune che abbiamo costruito per comunicare, fra tecnici di derivazione industriale e artisti a tutto tondo, una cosa che all’epoca sembrava roba da pazzi. E il ricordo di un viaggio formidabile che per un lungo tratto abbiamo affrontato assieme.>>