Anna Colafiglio

“Attori e alter ego digitali: riflessioni attraverso la lente delle masques technologiques”.

Il dibattito sul tema del doppio digitale dell’uomo è, al giorno d’oggi, quanto mai attuale. La nuova società digitale che si è sviluppata sulle piattaforme web costituisce, di fatto, una realtà parallela in cui ognuno è attore e attante di una vita ‘altra’ che esiste a tutti gli effetti, sebbene sia collocabile su un diverso piano rispetto a quello della realtà fisica. La costruzione del proprio personaggio virtuale implica una teatralità di fondo, insita nella possibilità di ‘costruirsi’ e ‘rendersi percepibili’ su un piano differente rispetto a quello strettamente concreto ed empiricamente osservabile.

Come afferma Brunella Eruli, «désormais les média nous proposent un univers où l’image n’est pas, n’est plus, la “rèproduction” de la réalité: elle “est” la réalité»[1]. Di questo aspetto parla anche Philip Auslander, il quale sostiene che il valore della presenza del performer dal vivo sia stato svalutato dall’odierna cultura mediatizzata: «when we go to a concert employing a large video screen, for instance, what do we look at? Do we concentrate our attention on the live bodies or are our eyes drawn to the screen, as Benjamin’s postulate of our desire for proximity would predict?» [2].

Lasciando da parte, in questa sede, le ricadute socio-antropologiche che questo cambiamento strutturale comporta, ci si concentrerà sulle modalità attraverso cui la realtà digitale è giunta a permeare il ramo delle arti performative, la cui storia, sin dalle origini, incontra spesso il tema del doppio dell’attore – il quale è già, egli stesso, un doppio dell’uomo da cui è agito –. Steve Dixon parla di enhanced theatre per definire quell’esperienza teatrale ‘aumentata’ dall’uso delle tecnologie in scena, che amplificano gli aspetti peculiari del medium teatrale[3]; Steve Benford e Gabriella Giannachi definiscono mixed reality performances quelle tendenze performative che uniscono reale e virtuale, spettacolo dal vivo e interazione uomo-tecnologia[4]. Ricercatori attivi in campo teatrale, artisti digitali e programmatori si interrogano con interesse sempre maggiore su quali possano essere le interazioni tra la realtà e gli universi digitali, mondi a sé stanti moltiplicabili all’infinito e in infinite forme. Il teatro e le arti performative tutte riflettono, in particolare, sull’impatto che queste realtà ‘altre’ possono avere sulla percezione scenica, sulla professione dell’attore, sulle possibilità della messa in scena e sulla fruizione del pubblico.

Tra le declinazioni che questa contaminazione può assumere, quella del doppio virtuale dell’attore, inteso come avatar animato attraverso un sistema di Motion Capture[5] e che si muove in un universo digitalmente costruito, ha sicuramente un impatto molto significativo sui principali aspetti della performance dal vivo. Il performer è vestito di una tuta aderente con dei marcatori di movimento, che ne condiziona l’azione, ed è chiamato ad assumere il controllo di un corpo virtuale la cui esistenza implica l’impiego di due piani spaziali: quello reale e quello virtuale, che è un mondo del tutto differente. Uno dei primi terreni d’impiego della MoCap è stato il settore della danza contemporanea[6]. Come sostiene Antonio Pizzo, nella performance del danzatore il corpo è spogliato dalla componente narrativa che caratterizza, invece, l’azione dell’attore nel teatro, nel cinema e nel gaming; egli può dunque puntare all’espressività e alla rappresentazione della volumetria del corpo[7]. Nel caso dell’attore, il mezzo pone una serie di problemi in più; attualmente, la MoCap è utilizzata nei contesti di cinema e gaming molto più che nella performance teatrale. Ripercorrendo alcune esperienze di ricerca a livello nazionale e internazionale, si analizzeranno degli esempi di applicazione di questa tecnologia al lavoro dell’attore e del regista, insieme ad alcune possibilità drammaturgiche che hanno trovato spazio in seguito a queste sperimentazioni.

Gli studi di Matt Delbridge, che si concentrano principalmente sull’attore cinematografico, evidenziano la complessità della relazione tra l’attore e il suo avatar virtuale, le cui criticità si legano, in particolar modo, al controllo di un movimento che ha luogo in uno spazio diverso da quello in cui, concretamente, l’interprete si muove. Spesso gli ambienti di cattura sono asettici, privi di riferimenti spaziali e di contesto, privi di ingombri e oggetti di scena; questo sistema richiede un nuovo tipo di approccio alla performance, e afferma la necessità di una formazione specifica che vada a ridefinire il concetto stesso di presenza nello spazio. Sottolineando questa stessa problematica,

Daniel Kade sostiene che la qualità della performance degli attori MoCap dipenda molto dalla capacità di questi ultimi di immaginare la scena in cui stanno recitando, e di immedesimarsi nel ruolo che sono chiamati a interpretare[8]. L’analisi di Kade parte da una serie di questionari consegnati ad attori e registi MoCap di diversa formazione, da cui emerge un quadro interessante circa le circostanze di lavoro e le esigenze degli uni e degli altri. Per migliorare la propria performance, gli attori segnalano la necessità di un’evoluzione della pratica verso una maggiore disponibilità di riferimenti visivi, oggetti e ingombri di scena, costumi; affermano inoltre il bisogno di ricevere più dati possibili riguardo i personaggi, l’ambiente in cui si muovono e la sua collocazione temporale, informazioni cui non sempre possono accedere con facilità. Dai questionari consegnati ai registi, sono invece emerse le caratteristiche principali di cui un attore MoCap deve essere provvisto: creativo e dotato di grande capacità immaginativa, egli deve essere in grado di esprimere la propria emozionalità attraverso una gestualità chiara e pulita, limitando al massimo il ricorso alla mimica facciale. Quest’ultima infatti, come si vedrà, può costituire un vincolo per la cattura del movimento, poiché riduce considerevolmente l’espressività corporea diventando il veicolo semantico preponderante dell’emozionalità dell’interprete.

Anche David Cage, fondatore dell’azienda di videogiochi Quantic Dream, si esprime sulla particolarità della recitazione in un ambiente MoCap paragonandola all’esperienza dell’attore in quello che chiama minimalist theatre[9]: qui la performance avviene su un palcoscenico completamente vuoto, che costringe il performer a un notevole sforzo di immaginazione. In questa situazione, la figura del regista risulta fondamentale al fine di contestualizzare ciascuna azione.

John Dower, regista di performance MoCap soprattutto nell’ambito del gaming, afferma:

“Io ero autorizzato ad avere l’intero script di tutte le scene, ed era circa cento pagine. Gli attori, al contrario, non potevano averlo; veniva data loro solo la singola scena da girare il giorno seguente, o addirittura lo stesso giorno. Ciò accade perché le produzioni sono molto preoccupate che possano trapelare informazioni sulla storia. […] Quindi [l’interprete] deve essere in grado di comprendere rapidamente la situazione e, in pochi minuti, realizzare ciò di cui ha bisogno di sapere al fine di eseguire efficacemente le sue azioni. Puoi immaginare come reagirebbe un attore tradizionale se gli dessi la scena, magari anche abbastanza lunga, solo mezz’ora prima di eseguirla. […] In più, l’attore si trova in uno studio che non somiglia a nessun altro posto dove probabilmente ha già lavorato e possono mancargli gli elementi dai quali aveva imparato a trarre le proprie indicazioni, i propri riferimenti per la creazione del personaggio.[10]

Dower ha lavorato a lungo nel mondo del gaming, fino a sentire l’esigenza di fondare, insieme all’attore Oliver Hollis-Leick, la scuola The Mocap Vaults[11]: attiva tra Londra e Los Angeles, è uno dei principali centri di formazione per registi, attori e animatori che operano, a vario titolo, nell’industria della MoCap. A proposito delle tecniche attoriali, Dower afferma la necessità di una formazione di tipo teatrale per gli attori che si avvicinano alla MoCap: l’attore teatrale è infatti pienamente consapevole della propria presenza, della propria fisicità e di come questa entri in relazione con il pubblico[12]. Lo stesso Oliver Hollis-Leick, attore MoCap di grande esperienza, conferma questa visione, affermando che gli attori cinematografici tendono ad apparire molto rigidi nella loro trasposizione virtuale, in quanto abituati a utilizzare molto la mimica facciale nella loro pratica recitativa; gli attori di teatro, invece, sono spesso più inclini all’uso dell’intero corpo, poiché hanno necessità di rendere il loro movimento percepibile anche dagli spettatori più lontani dal palcoscenico.

I think people often underestimate the ability of motion capture to detect falseness. Any hesitation, tension or discomfort is immediately read by the technology and will look out of place. The hardest thing about motion capture is the rawness of it. On a movie set, you’ve got costume, props, and other actors around you, you know exactly where the camera is and you know what kind of size of shot it is and you can just perform. In motion capture, you have a bare warehouse-like set with no props, no costumes, sometimes you have no other actors in the room and you don’t necessarily even know where the camera is.[13]

La dimensione fortemente teatrale della performance MoCap è alla base del concetto di Performance Capture introdotto da Matt Delbridge, con il quale si identifica una pratica che va oltre la semplice cattura del movimento ‘fisico’, abbracciando una visione più ampia e completa della performance attoriale inclusiva della sfera emozionale e semantica del movimento stesso[14]; essa comprende dunque l’azione di tutte le figure creative e tecniche che concorrono alla creazione dell’avatar e del suo universo digitale. Delbridge utilizza proprio lo spazio teatrale per mettere in atto diverse sperimentazioni che riguardano il movimento dell’attore e la sua relazione con i piani ‘altri’ in cui il suo avatar si muove[15]: attraverso il coinvolgimento di attori e performer di differente formazione, Delbridge cerca di risolvere il problema dell’asetticità dello spazio recitativo in cui la cattura del movimento avviene, dando ai partecipanti la possibilità di vedere di fronte a sé l’avatar posizionato sul palcoscenico di un teatro virtuale. In questo modo, l’attore può migliorare la percezione di sé e delle proprie azioni, attraverso la messa in campo di una relazione uomo-ambiente che sarebbe impossibile trovare nel solo luogo dell’azione reale. L’approccio alla materia di Delbridge è diametralmente opposto a quello di John Dower e The Mocap Vaults: Dower afferma, infatti, la necessità di nascondere, agli occhi dell’attore, qualsiasi monitor in cui questi possa vedere il riflesso di se stesso, per evitare che si concentri sul proprio aspetto più che sulla propria performance.

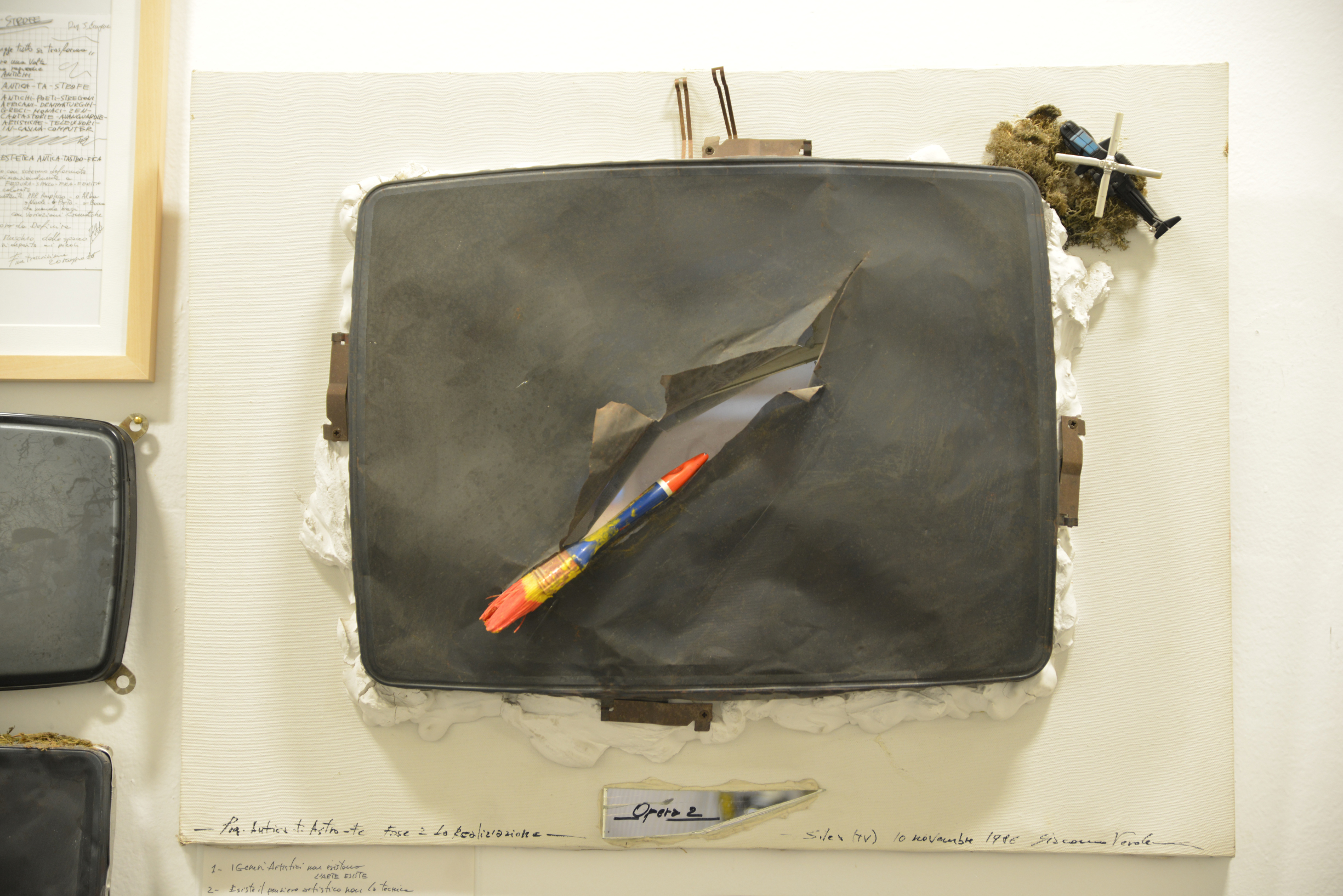

In ambito italiano, sono pochissimi i casi in cui la tecnologia MoCap è stata applicata al teatro; tra questi, figura senza dubbio l’Ubu Incatenato di Fortebraccio Teatro (2005)[16] [inserire fig.1: Fortebraccio Teatro, Ubu Incatenato, regia di Roberto Latini, 2005. Foto di Cristiano Colangelo]. Qui Roberto Latini veste i panni di Ubu indossando un esoscheletro che lo incatena e ne capta il movimento, creando un avatar proiettato in un universo virtuale; è «il cyber-attore cablato, il cyborg miscela di organico, mitologico e tecnologico [che] assume i connotati della Supermarionetta profetizzata da Gordon Craig, dell’attore-architettura ambulante di Oskar Schlemmer e infine dell’attore biomeccanico mejercholdiano»[17].

Tutto l’esoscheletro è immaginabile come un microfono del corpo che lo amplifica e lo rende altrimenti visibile e mutabile, lo moltiplica, lo reinventa anche graficamente […]. Tutti [i personaggi] possono essere animati, interpretati, attraversati da un solo attore. Come fosse il marionettista di se stesso, come fosse contemporaneamente il proprio suo autore, infine, dipendente solo da stesso. […] L’attore sul palco è assistito da un informatico che nella scenografia realizzata è posto sotto al palcoscenico, come se fosse nella baracca del burattinaio.[18] L’Ubu Incatenato si chiude con l’esoscheletro appeso al centro della scena, inerme; una carcassa che, privata dell’attore, non può portare avanti lo spettacolo.

Si evince come il palcoscenico teatrale ponga delle questioni assolutamente differenti da quelle dell’ambiente di cattura impiegato in ambito cinematografico o del gaming. Andrea Brogi, artista digitale fondatore di XLab parla del rapporto tra la tecnologia e l’attore nella performance teatrale, rilevando degli elementi che si collocano agli antipodi di quanto detto finora:

Quando lo spettacolo va in scena l’attore conosce alla perfezione lo spazio che lo circonda, è effettivamente come un abito di scena che gli è stato cucito addosso, in cui si deve sentire a suo agio e di cui deve avere la piena padronanza. […] La mia attenzione si è sempre concentrata sulle necessità espressive dell’attore in modo da far diventare l’ambiente virtuale una sorta di estensione del suo corpo e della sua gestualità. Prima quindi si progetta l’aspetto interattivo che l’attore deve avere con la scena, dopodiché si scelgono le tecnologie adatte e si inizia la fase di sperimentazione con l’attore.[19]

Nelle parole dei registi e degli artisti digitali che lavorano per il teatro, torna di frequente il concetto di tecnologia come estensione del corpo dell’attore, che influisce radicalmente sulla creazione e sul suo modo di stare in scena[20].

Sul piano della ricerca in area nazionale, si segnala il lavoro svolto nell’ambito del Master in Animazione 3D Autodesk Maya e Compositing dell’Università La Sapienza di Roma[21]. In collaborazione con il Centro Teatro Ateneo, il Laboratorio di Biomeccanica dell’Università di Roma Foro Italico e The Pool Factory[22], l’équipe, composta da Maria Grazia Berlangieri, Flaviano Pizzardi, Ferruccio Marotti, Aurelio Cappozzo e Mounir Zok, ha messo in campo un gruppo di studio sulla relazione tra tecniche attoriali e animazione 3D in tempo reale[23]. Dopo diversi esperimenti con attori di provenienza cinematografica e teatrale in senso lato, la cui cattura del movimento è risultata funzionale ma poco espressiva, nel 2010 l’équipe ha iniziato a lavorare con attori di Commedia dell’Arte, il cui intervento si è rivelato molto efficace: formati attraverso un determinato training psicofisico e abituati ad agire su palcoscenici semivuoti, con una maschera sul volto a privarli della mimica facciale, essi sono stati in grado di infondere una maggiore espressività all’avatar virtuale. Per evitare che l’attenzione degli attori si focalizzasse troppo sulle novità tecnologiche peculiari dell’ambiente di cattura MoCap, i canovacci sono stati sostituiti da nuove drammaturgie, riportando l’attenzione sul testo e sugli elementi più tradizionali del lavoro d’attore. Gli interpreti hanno rilevato un’amplificazione del proprio immaginario attoriale, come reazione allo straniamento dato da quel set così privo di riferimenti spaziali, di luci, di pubblico, di punto di vista: «si tratta di estrema libertà, ma non avere paletti per un attore è, non dico rischioso, ma qualcosa che certamente disorienta e spiazza»[24].

Sul piano della tecnologia utilizzata come espediente formativo per l’attore è intervenuto Massimo Bergamasco, direttore del TECIP – Istituto di Tecnologie della Comunicazione, dell’Informazione e della Percezione della Scuola Superiore Sant’Anna di Pisa[25], nell’ambito del convegno internazionale di studi Masques technologiques – Altérités hybrides de la scène contemporaine[26]. L’intervento di Bergamasco ha presentato i risultati delle ricerche attualmente in corso presso il centro di eccellenza, che opera nel duplice ambito della robotica indossabile a fini riabilitativi e dello sviluppo di hardware e software per ambienti virtuali immersivi e realtà aumentata. Nel corso degli anni, l’Istituto si è confrontato con le arti performative in diverse occasioni. All’interno del progetto europeo Beaming[27] sul teletrasporto virtuale, due nuclei di attori presenti a Londra e Barcellona, dotati di caschi immersivi, si sono incontrati all’interno di un unico ambiente virtuale; un regista ha interagito con loro pur trovandosi in un terzo ambiente fisico, lontano da entrambi i gruppi, dando prova concreta del fenomeno chiamato immersive telepresence. Nel luglio 2017, in occasione della III edizione fiorentina del META – Meeting of European Theatre Academies, l’Istituto TECIP e il PERCRO – Laboratorio di Robotica Percettiva hanno collaborato con l’Accademia Teatrale di Firenze in occasione del workshop Realtà virtuale applicata alla pedagogia teatrale e alle arti performative[28], incentrato sui sistemi di formazione attoriale e registica basati sull’utilizzo di tecnologie quali sistemi di visualizzazione immersiva e di rilevamento motorio, sfruttando il valore trasformazionale degli ambienti virtuali per cambiare l’esperienza percettiva del performer e ottenere specifici risultati sulla scena.

La riflessione messa in atto dal convegno parigino Masques technologiques ha avuto il merito di ampliare il dibattito sul doppio virtuale alla sua applicazione sul palcoscenico. La relazione con la MoCap è stata analizzata dal punto di vista del performer, del regista e del formatore teatrale, sottolineando le modalità attraverso cui l’utilizzo di questa tecnologia può diventare un espediente drammaturgico per la scena e interagire con la realtà fisica. Hanno partecipato alle giornate di studio professionisti provenienti da diversi ambiti disciplinari: ricercatori attivi nel campo degli studi teatrali, registi, attori, artisti digitali e programmatori. L’incontro tra queste professionalità ha messo in campo una serie di riflessioni a tutto tondo sull’utilizzo delle nuove tecnologie applicate a una forma di recitazione e creazione che, per molti versi, ha a che fare con la teatralità più classica: quella che vede l’attore relazionarsi con la maschera che porta sul volto e che, dunque, abita in certo modo il suo corpo. Partendo da una panoramica relativa all’utilizzo della maschera tra XIX e XX secolo, realizzata da Guy Freixe dell’Université de Besançon[29], si è giunti all’analisi di quella che, a oggi, è la relazione tra l’attore e il suo doppio, delle modalità di interazione tra il performer in scena e il suo alter ego digitale, della nuova dimensione spaziale che questa dualità scenica e interpretativa comporta. L’oggetto-maschera, privando l’attore della propria mimica facciale, lo spinge a cercare un codice espressivo che si caratterizza per movenze tipizzate e stilemi archetipici, imponendo al corpo dell’attore una determinata codificazione e una pulizia di movimento che, come si è visto, sono centrali anche nei processi di acquisizione del movimento propri della MoCap. Capace di trasformare il corpo in un ibrido che trascende l’umano, la maschera viene qui a rappresentare l’essenza stessa del teatro, che di per sé è luogo di trasfigurazione del reale, di ‘realtà aumentata’; costituisce una forma di alterità paragonabile all’approccio messo in campo dalle tecnologie digitali e dall’utilizzo del doppio in forma di avatar. Ci si chiede se, al giorno d’oggi, le tecnologie digitali possano essere percepite e utilizzate come vere e proprie maschere contemporanee: risoluzione che porta con sé la necessità di appellarsi ad appositi codici interpretativi, approcci al materiale scenico e percorsi di formazione attoriale mirati a questa modalità di creazione e azione, vero e proprio ‘moltiplicatore di realtà’.

Duccio Bellugi, storico attore del Théâtre du Soleil, ha affermato di utilizzare le stesse tecniche della recitazione con maschera nel dare vita all’avatar digitale; ha così lasciato spazio alla tecnologia, mettendo in secondo piano l’uomo-attore. «Spesso – ha affermato Bellugi – si pensa alla maschera come a un oggetto che riguarda solo il volto dell’attore, ma questo è un errore: nella recitazione con maschera è tutto il corpo a essere messo in gioco»[30]. La grammatica gestuale della maschera aiuta l’attore ad allontanarsi da un approccio realistico alla recitazione; è dunque un ausilio sostanziale alla sua relazione con il mezzo tecnologico.

Avviato nel 2015, il progetto di ricerca e creazione Masques et Avatars indaga la presenza dell’attore all’interno di una scena ‘aumentata’ da dispositivi digitali, in questo caso rappresentati dalla tecnologia MoCap. Come ha evidenziato Erica Magris, che con il suo intervento ha condotto la discussione alle radici della ricerca intrapresa nell’ambito del progetto, l’impatto che le tecnologie hanno sulla performance attoriale è evidente. Proprio questa riflessione ha condotto l’équipe a un’approfondita analisi delle dinamiche dello stare in scena dell’interprete; la maschera, da subito, si è configurata come un dispositivo ottimale per avvicinarsi a questo concetto di attore tecnologicamente aumentato. L’analisi di Erica Magris ha evidenziato come l’impiego della ‘maschera tecnologica’ sulla scena, nelle sue diverse declinazioni, influenzi profondamente la performance dell’attore. La differenza più grande che sussiste tra la maschera teatrale e quella tecnologica parte proprio dalla soggettività dell’attore: se la prima è un oggetto immobile che si applica al corpo e ‘vive’ grazie all’azione dell’interprete, quella tecnologica è un dispositivo che si configura come il risultato di una serie di elementi, il cui funzionamento e la cui resa scenica sono determinati dall’azione multipla e congiunta di più soggetti coinvolti. Il corpo dell’attore è così mediatizzato: i dispositivi tecnologici lavorano sulla sua immagine, riducendo le azioni in dati che possono essere manipolati e rielaborati all’infinito e che giungono, spesso, a distaccarsi radicalmente dall’attore, dal suo corpo e dalla sua influenza di essere vivente. L’attore spesso innesca dei fenomeni, ma il modo in cui il suo movimento è trattato in postproduzione dipende dal sistema complessivo di lavoro; egli diviene dunque uno strumento, sezione di un meccanismo che prescinde, in ampia parte, dalla sua azione.

Con l’intervento L’altérité en scène: masques et doubles numériques de l’acteur, Giulia Filacanapa ha proposto una cronistoria dei punti di partenza e di arrivo della ricerca condotta nel corso del triennio, e qui giunta a conclusione con la presentazione di tre diversi esiti scenici, in cui attori mascherati hanno animato degli avatar virtuali[31]. Partendo da alcuni interrogativi fondamentali – in che modo l’attore mascherato e colui che anima l’avatar vivono la metamorfosi? Quali sono i parallelismi tra queste due tipologie di alterità? –, il gruppo di lavoro ha adottato da subito un approccio pratico alla ricerca e ha elaborato un dizionario di neologismi: l’attore in tuta MoCap[32] è diventato, così, mocapteur, ed è emersa una nuova figura, fondamentale per la resa finale, che è quella del manipulacteur. Quest’ultimo assume il controllo in tempo reale della presenza dell’avatar nello spazio, tramite un joystick molto simile a quello adoperato nei videogiochi. Alle figure del mocapteur e del manipulacteur si aggiungono quella dell’artista digitale, che crea lo spazio e il personaggio virtuale, e quella del regista. Il ruolo di quest’ultimo assume, in questo contesto, una complessità differente: egli deve infatti dirigere l’attore in carne e ossa partendo dallo specchio del suo movimento sull’avatar digitale; deve cercare, dunque, il mezzo affinché la resa finale dell’avatar corrisponda alle esigenze della scena, interrogandosi costantemente sui destinatari delle proprie indicazioni e dirigendo l’équipe secondo un’estetica coerente con il progetto di messa in scena.

Dal punto di vista spaziale, il mocapteur si muove su tre aree differenti: lo spazio fisico, nel quale il suo corpo ‘reale’ agisce; lo spazio virtuale, che spesso è caratterizzato da una maggiore connotazione scenica, e dunque drammaturgica, nel quale si muove l’avatar; lo spazio ‘drammatico-fisico’, a metà tra i due, nel quale si trova l’attore nel momento in cui anima un avatar o un personaggio. Il mocapteur deve, così, abitare uno spazio al confine tra realtà differenti, in cui la plausibilità dell’azione dipende dalla sua capacità di proiettare l’azione stessa in uno spazio ‘altro’, spesso preoccupandosi, al contempo, della credibilità ed efficacia del suo personaggio nello spazio reale.

La plausibilità espressiva dell’avatar è stata, da subito, uno dei punti focali per l’équipe di ricerca. Il miglioramento portato all’espressività dell’avatar dalla presenza della maschera sul volto dell’attore MoCap, è stato rilevato anche dal programmatore Cédric Plessiet, che ha sottolineato una variabile di contesto nella percezione del gesto attoriale: se in teatro questo è visto come un’azione intenzionale portatrice di significato, per l’animatore 3D è null’altro che un dato trasmesso al sistema. La maschera può essere un valido ausilio in questo senso poiché, facendo appello a una grammatica codificata del movimento, aiuta l’attore a rendere il suo gesto informaticamente più leggibile. Per chiarire questo nodo teorico, Plessiet ha citato il metodo attoriale di Andy Serkis: egli non recita mascherato, ma ha una tale padronanza della MoCap da rendere il dato del suo movimento perfettamente decifrabile dai suoi sviluppatori. Oggi, fuori dalle dinamiche delle grandi produzioni cinematografiche, questa è una situazione molto difficile da replicare, sia perché l’attore teatrale ha una minore dimestichezza con il mezzo tecnologico, sia perché, a livello economico, l’impiego di mezzi e risorse umane è di gran lunga inferiore.

Il regista e ricercatore Georges Gagneré, che da tempo si occupa dell’applicazione del digitale in teatro, ha lavorato con Plessiet nel corso del progetto di ricerca. Izabella Pluta ha analizzato la relazione tra queste due professionalità, che presenta numerosi punti critici derivanti da una lontananza di approcci e di vedute destinate, tuttavia, a convergere in nome di un risultato. La collaborazione tra i due settori ha permesso di generare una grande consapevolezza dei reciproci campi di analisi; le esigenze dell’attore sono sempre state al centro della ricerca, e i codici di programmazione sono stati scritti in funzione di quelli che gli attori e gli altri utilizzatori avevano definito come necessità legate alla performance. Gagneré ha sintetizzato così la fruttuosa collaborazione avuta con Plessiet nel corso del progetto:

“Ho chiesto a Cédric di costruirmi una prima piattaforma di manipolazione dell’avatar e di insegnarmi degli elementi che, a un certo punto, sarei stato in grado di gestire da solo, senza fargli delle domande semplicistiche o dovute al fatto che non mi ero preso la responsabilità di formarmi un minimo al suo linguaggio. Ci sono delle cose che non sapevo fare, e che non saprò mai fare; d’altra parte, ci sono cose di cui potevo iniziare ad appropriarmi, per esistere nel mondo di Cédric in totale complementarietà, ma mantenendo comunque un’indipendenza”.

Rémy Sohier, che lavora nel campo del gaming, si è occupato di costruire la scenografia virtuale per le performance afferenti al progetto. Ha sottolineato la complessità di creare una composizione scenografica per l’attore teatrale aumentato e di posizionarlo nella scena virtuale; i riferimenti cinematografici e fotografici con i quali opera abitualmente, si sono rivelati inadeguati alla condizione ibrida del teatro, in cui due realtà – quella fisica e quella virtuale – devono entrare in relazione.

Come ha sottolineato il regista e attore Boris Dymny, l’ambiente in cui l’avatar si muove, seppur bidimensionale, è basato sulle regole del 3D: nella costruzione dello spazio, gli artisti digitali ragionano infatti in termini tridimensionali – dove posizionare la camera, come strutturare il campo visivo in relazione al personaggio –. Nello spazio virtuale, la terza dimensione è data dal fatto che la camera può girare a trecentosessanta gradi attorno al personaggio, dando così un risultato in termini di tridimensionalità; è estremamente difficile trovare dei codici recitativi che possano funzionare allo stesso modo sia nello spazio reale a tre dimensioni, sia in uno spazio, di fatto, bidimensionale.

Il progetto Masques et Avatars ha concluso la ricerca con la messa a punto di tre esiti scenici, basati sulle sperimentazioni realizzate durante il percorso. Con una maggiore coscienza tecnico-pratica da parte dei registi e degli attori, e con una rinnovata attenzione verso la scena da parte dei programmatori, è iniziato il lavoro sulla creazione. In tutti e tre i casi la tecnologia MoCap è stata utilizzata come espediente drammaturgico, con diverse modalità e diversi esiti. Le équipe hanno lavorato su avatar preesistenti, piuttosto statici e dalla configurazione molto semplice; il lavoro congiunto del mocapteur e del manipulacteur ha permesso di dar loro una maggiore presenza rendendoli scenicamente più efficaci – fermi restando i limiti imposti dalla tecnologia utilizzata, che hanno determinato una scarsa efficacia dell’azione in tempo reale e reso il lavoro degli attori piuttosto complicato –.

In Agamemnon Redux[33], Andy Lavender ha effettuato un lavoro sullo sguardo e sullo scarto di prossimità tra le attrici in scena e gli avatar nello spazio virtuale, luogo in cui avviene tutta l’azione scenica

Le due attrici, che vediamo agire sul palcoscenico con maschere balinesi sul volto, non hanno altro ruolo che quello di dare il movimento agli avatar in tempo reale: esse agiscono i personaggi ora guardando l’azione che avviene sullo schermo, ora stando di fronte al pubblico. Andy Lavender, docente presso la University of Warwick[34], ha evidenziato il paradosso cui è sottoposto il corpo umano nel momento in cui viene trasfigurato dall’oggetto-maschera o dalla tecnologia MoCap: entrambi i dispositivi giungono alla performance attraverso un processo di dissimulazione, poiché chiarificano il movimento e definiscono l’azione attraverso la negazione del corpo o del viso dell’attore. Per Agamemnon, Lavender ha adottato un approccio aderente ai principi della maschera: una cattura del movimento teatralizzata, in cui l’attore è in scena e crea l’avatar in tempo reale, rendendo lo spettatore cosciente dei mezzi con cui l’avatar stesso è realizzato. Gli avatar di Lavender non interagiscono con gli attori, ma sono da essi diretti come se fossero marionette; la loro gestualità è dunque evocativa, tratteggiata, mai realistica.

In La vie en rose. De la clinique à l’éternité[35], Giulia Filacanapa ha utilizzato la scena virtuale come luogo del ricordo, simbolo di uno spazio mentale ‘altro’ rispetto all’azione drammaturgica che ha luogo sulla scena

Gli attori, che indossano maschere in cuoio, interpretano dei personaggi sul palcoscenico e, al contempo, muovono gli avatar presenti nello spazio virtuale, luogo del pensiero di un malato di alzheimer che interagisce con le immagini prodotte dalla propria mente. La sincronizzazione dell’attore con il sistema MoCap avviene in scena: l’artificio svelato è parte integrante dello spettacolo.

Nella terza restituzione, La psychanalyse augmentée[36], la scena virtuale rappresenta il luogo dell’inconscio del protagonista, che ricorda episodi della sua infanzia durante una seduta di psicanalisi. In questo caso, i due protagonisti sono al centro della scena, rivolti verso il pubblico, mentre sui due lati, fuori dai riflettori, altri attori animano gli avatar digitali; la scena virtuale rappresenta un altro piano di rappresentazione rispetto alla scena fisica, e non interagisce con essa.

Le esperienze riportate dagli attori convolti nel progetto Masques et Avatars sono significative, soprattutto se comparate al punto di vista dei programmatori informatici che ne hanno seguito le diverse tappe nella creazione. Léandre Ruiz ha rilevato la necessità, per l’attore, di rinegoziare il proprio linguaggio espressivo e percettivo nella relazione con l’avatar virtuale, il quale è frutto di una responsabilità condivisa assai nuova per l’interprete; questi elementi di novità implicherebbero l’esigenza di seguire percorsi di formazione finalizzati all’acquisizione di nuovi strumenti espressivi. Cercare un ‘respiro’ comune a quello dell’avatar è risultato, per gli attori, molto difficoltoso: come confermato dal programmatore Cédric Plessiet, l’avatar virtuale, a causa di fattori principalmente derivanti da tecniche di calcolo, possiede un ritmo ‘vitale’ più lento rispetto a quello dell’interprete. Questa differenza crea uno scarto complicato da gestire, che determina impazienza tanto nell’attore quanto nel regista, riducendo la plausibilità dell’avatar agli occhi del pubblico.

Plessiet, da tempo impegnato nella definizione delle possibilità di autonomia dei personaggi virtuali, ha ipotizzato che la plausibilità dell’avatar possa dipendere dalla sua capacità di generare movimenti in autonomia, partendo dalla respirazione – il che potrebbe comportare non poche, ulteriori criticità nella relazione con l’interprete –. Oggi, dal punto di vista della programmazione, quanto c’è di più vicino all’autonomia è l’effetto creato dall’animazione comportamentale, sempre più diffusa anche nel campo del gaming: una simulazione basata su una serie di algoritmi genetici e reti neurali ‘istruite’. Plessiet ha operato una differenziazione tra il Golem, inteso come robot, che agisce autonomamente in seguito a un input esterno, e l’attore, che agisce invece grazie a un’intenzionalità e a un movimento che provengono da sé; l’obiettivo dei programmatori consiste nel far raggiungere al personaggio virtuale lo stesso status dell’attore, rendendolo a sua volta autore autonomo della propria intenzione e della propria azione. Anche l’artista digitale Jean-François Jégo, del laboratorio INRéV – Images Numériques et Réalité Virtuelle, si è interrogato sulle possibilità di autonomia per l’attore digitale: essa crea un’illusione di realtà che induce alla risoluzione per cui, se un personaggio è autonomo, allora questi è potenzialmente vivo, interrogando la possibile empatia o simpatia che si prova nei suoi confronti.

Si potrebbe ragionare molto sulla questione dell’autonomia dei personaggi virtuali, ma gli artisti digitali intervenuti sono stati concordi nell’affermare che, per ottenere un risultato ottimale, sarebbe necessario che ricercatori, programmatori e animatori collaborassero con gli attori al fine di ‘creare’ le capacità dell’attore virtuale, istruendo una specifica rete neurale. Nell’improvvisazione di due attori che recitano con maschera, non si sa quello che essi si diranno, ma si sa che entrambi resteranno sicuramente nella linea del proprio personaggio; ed è proprio in questa nozione di ‘personaggio’ che risiede una pista possibile per la creazione dell’attore virtuale autonomo.

Tag: motion capture, avatar, maschera, attore, teatro, performance, tecnologia, digitale, corpo

[1] B. Eruli, ‘Le silence des sirènes’, Puck. La marionnette et les autres arts. Images virtuelles, n. 9, 1996, p. 9.

[2] P. Auslander, Liveness. Performance in a Mediatized Culture, London-New York, Routledge, 2008, II ed., p. 42.

[3] Cfr. S. Dixon, Digital Performance. A History of New Media in Theater, Dance, Performance Art, and Installation, Cambridge-London, The MIT Press, 2007.

[4] Cfr. S. Benford, G. Giannachi, Performing Mixed Reality, Cambridge-London, The MIT Press, 2011; cfr. inoltre S. Broadhurst, J. Machon (edited by), Performance and Technology. Practices of Virtual Embodiment and Interactivity, London, Palgrave-Macmillan, 2011.

[5] Da ora in poi MoCap.

[6] Sull’uso della MoCap in scena hanno lavorato coreografi del calibro di Merce Cunningham, William Forsythe, Bill T. Jones, Trisha Brown, spesso in collaborazione con l’artista digitale Paul Kaiser. Per approfondimenti, cfr. in particolare M. Cunningham, Il danzatore e la danza. Colloqui con Jacqueline Lesschaeve, Torino, EDT, 1990; A. Menicacci, E. Quinz (a cura di), La scena digitale. Nuovi media per la danza, Venezia, Marsilio, 2001; E. Manning, Relationscapes. Movement, Art, Philosophy, Cambridge-London, The MIT Press, 2009; F. Mazzocchi, A. Pizzo, A. Pontremoli (a cura di), Danza, media digitali, interattività, Acireale, Bonanno, 2012; S. Portanova, Moving without a body. Digital Philosophy and Choreographic Thoughts, Cambridge-London, The MIT Press, 2013; N. Salazar Sutil, Motion and Representation. The Language of Human Movement, Cambridge-London, The MIT Press, 2015; L.G. Monda, Choreographic bodies. L’esperienza della Motion Bank nel progetto multidisciplinare di Forsythe, Roma, Dino Audino Editore, 2016; E. Pitozzi, ‘Bodysoundscape. Perception, Movement, and Audiovisual Developments in Contemporary Dance’, in Y. Kaduri (edited by), The Oxford Handbook of Sound and Image in Western Art, Oxford, Oxford University Press, 2016.

[7] Cfr. A. Pizzo, ‘Attori e personaggi virtuali’, Acting Archives Review, a. I, n. 1, aprile 2011, pp. 83-118.

[8] Cfr. D. Kade, ‘Towards Stanislavski-based Principles for Motion Capture Acting in Animation and Computer Games’, in AA.VV., CONFIA – 2nd International Conference in Illustration and Animation, Porto, IPCA, 2013, pp. 277-292.

[9] D. Cage intervistato da P. Davidson, ‘David Cage: “We Can Use Technology to Say Something”’, USgamer, 4 settembre 2013, https://www.usgamer.net/articles/david-cage-we-can-use-technology-to-say-something [accessed 21 April 2018].

[10] J. Dower intervistato da A. Pizzo, ‘Il lavoro con la motion capture: il regista e l’attore’, Acting Archives Review, a. VI, n. 11, maggio 2016, pp. 72-74. Su questi argomenti si è espresso anche Andy Serkis, attore cinematografico tra i più esperti di recitazione MoCap, in un’intervista a S. Silberman, ‘Q&A: King of Mo-Cap Andy Serkis on Digital Acting and Gollum’s Oscar Diss’, Wired, 14 settembre 2007, https://www.wired.com/2007/09/pl-serkis/ [accessed 22 April 2018].

[11] Cfr. www.themocapvaults.com [accessed 24 March 2018].

[12] J. Dower intervistato da A. Pizzo, ‘Il lavoro con la motion capture: il regista e l’attore’, cit., pp. 76-77.

[13] O. Hollis-Leick intervistato dalla redazione di CGSociety, ‘What actors and directors need to know about motion capture to stay competitive’, CGSociety, 2015, http://www.cgsociety.org/news/article/1181/what-actors-and-directors-need-to-know-about-motion-capture-to-stay-competitive [accessed 25 March 2018].

[14] Cfr. M. Delbridge, Motion Capture in Performance. An Introduction, London-New York, Palgrave-Macmillan, 2015, pp. 2-5; A. Pizzo, ‘L’attore e la recitazione nella motion capture’, Acting Archives Review, a. VI, n. 11, maggio 2016, pp. 39-40.

[15] Cfr. M. Delbridge, Motion Capture in Performance, cit., p. 22 sgg.; R. Roihankorpi, M. Delbridge, ‘Hamlet’s Norwegian Doll’s House: reframing embodied knowledge with virtual architectonics of performance’, Arti dello Spettacolo / Performing Arts. New Frontiers: Live Performances, Archives and Digital technology, a. III, n. 3, 2017, pp. 49-58.

[16] Ubu Incatenato, di R. Latini e G. Misiti da A. Jarry, con R. Latini e P. Pasteris, regia R. Latini, musiche e aiuto regia G. Misiti, ambienti digitali interattivi A. Brogi / XLab Factory, assistente motion capture P. Pasteris, luci e direzione tecnica M. Mugnai, video in chroma key P. Magnani. Prima rappresentazione: Udine, Teatro San Giorgio, 14 dicembre 2005. Cfr. F. Bini, S. Terranova, ‘Ubu Incatenato (2005)’, Sciami | Nuovo Teatro Made in Italy, https://nuovoteatromadeinitaly.sciami.com/roberto-latini-ubu-incatenato-2005/ [accessed 24 March 2018]; R. Latini, ‘Incatenando Ubu’, Sciami | Nuovo Teatro Made in Italy, https://sciami.com/scm-content/uploads/sites/7/2017/04/Roberto-Latini-note-regia-Ubu-incatenato-2005.pdf [accessed 24 March 2018]; S. Terranova, ‘Ubu incatenato. Presentazione’, Sciami | Nuovo Teatro Made in Italy, https://sciami.com/scm-content/uploads/sites/7/2017/04/Roberto-Latini-descrizione-Ubu-Incatenato-2005-Serena-Terranova-2015.pdf [accessed 25 March 2018].

[17] A.M. Monteverdi, Nuovi media, nuovo teatro. Teorie e pratiche tra teatro e digitalità, Milano, Franco Angeli, 2011, p. 190.

[18] R. Latini, ‘Incatenando Ubu’, cit.

[19] A. Brogi intervistato da A.M. Monteverdi, ‘Andrea Brogi, Motion Capture Teatrale’, Digicult, http://digicult.it/it/digimag/issue-024/italiano-andrea-brogi-motion-capture-teatrale/ [accessed 24 March 2018].

[20] Interessanti testimonianze di artisti digitali, registi, attori e performer che lavorano con la tecnologia in scena sono rintracciabili in A.M. Monteverdi, Nuovi media, nuovo teatro, cit., pp. 227-267.

[21] Cfr. M.G. Berlangieri, ‘Motion Capture e Commedia dell’Arte: un case study’, in P. Bertolone, A. Corea, D. Gavrilovich (a cura di), Trame di meraviglia. Studi in onore di Silvia Carandini, Roma, UniversItalia, 2016, pp. 39-45; M.G. Berlangieri, ‘Performing Arts, gli archivi digitali e la narrazione interattiva’, Arti dello Spettacolo / Performing Arts. New Frontiers: Live Performances, Archives and Digital technology, a. III, n. 3, 2017, pp. 16-27.

[22] The Pool Factory è una delle più importanti realtà italiane che operano nel campo dell’animazione 3D; cfr. http://thepool.it/ [accessed 28 March 2018].

[23] Di questioni affini, traslate principalmente nel campo della danza e dell’esecuzione musicale, si occupa tutt’oggi il centro di ricerca genovese Casa Paganini / InfoMus Lab, sviluppatore del noto software EyesWeb. Cfr. A. Camurri, ‘Il progetto EyesWeb per musica, danza e teatro’, in A. Menicacci, E. Quinz (a cura di), La scena digitale. Nuovi media per la danza, cit., pp. 67-78; http://www.infomus.org/index.php [accessed 12 May 2018].

[24] Intervista all’attore I. Picciallo, citato in M.G. Berlangieri, ‘Motion Capture e Commedia dell’Arte: un case study’, cit., pp. 44-45.

[25] Cfr. http://www.santannapisa.it/it/istituto/tecip/tecip-institute [accessed 12 May 2018].

[26] Il convegno si è svolto a Parigi, presso Le Cube – Centre de création numérique, nei giorni 14 e 15 dicembre 2017, e si è configurato come il punto d’arrivo del progetto triennale Labex Arts H2H La scène augmentée: jeu de l’acteur, pratiques de création, modes de transmission, ideato e diretto da Erica Magris con Giulia Filacanapa, Georges Gagneré e Cédric Plessiet (Université Paris 8), con la collaborazione di Josette Féral (Université Sorbonne Nouvelle). Oltre ai relatori di cui si è fatta menzione all’interno di questo saggio, hanno preso parte al convegno Réjane Dreifuss (Zurich University of the Arts), con un intervento sul game theatre, che rielabora i meccanismi dei videogiochi per creare un nuovo tipo di interazione in cui gli spettatori sono parte attiva nella creazione dello spettacolo; Simon Hagemann (Université de Nancy), che ha analizzato il fenomeno del coinvolgimento interattivo dello spettatore attraverso interfacce mediatizzate, all’interno di quello che prende il nome di immersive theatre; Paolo Héritier (Università degli Studi di Torino), che ha proposto una riflessione sul contesto normativo dell’immagine del robot; Anna Maria Monteverdi (Università degli Studi di Milano), che ha analizzato la ‘maschera teatrale’ scenica che caratterizza il teatro di Robert Lepage – per approfondimenti su questo tema, cfr. A.M. Monteverdi, Memoria, maschera e macchina nel teatro di Robert Lepage, Meltemi 2018 –; Anton Rey (Zurich University of the Arts), che ha esposto la lavorazione del progetto Action Avatar, realizzato in collaborazione con centri neurologici di eccellenza, le cui sperimentazioni sono al momento concentrate sui metodi di face tracking.

[27] Il progetto si è sviluppato dal 2011 al 2013 e ha visto la Scuola Superiore Sant’Anna comparire nel team di progetto insieme ad altri centri di eccellenza europei, leader nella ricerca e nello sviluppo. Cfr. http://www.beaming-eu.org/home [accessed 12 May 2018].

[28] Cfr. M. Brighenti, META 2017. Intervista Bergamasco Bartolini – Virtual Reality and Theatre, 13 luglio 2017, https://www.youtube.com/watch?v=HxWX7MjMF-M [accessed 13 May 2018].

[29] Cfr., tra gli altri, G. Freixe, Les utopies du masque sur les scènes européennes du XX siècle, Paris, L’Entretemps, 2010; A.M. Monteverdi (a cura di), La maschera volubile. Frammenti di teatro e video, Titivillus, Corazzano (Pisa), 2000.

[30] D’ora in avanti, citazioni e rimandi afferiscono agli interventi presentati durante il convegno in oggetto.

[31] Tre spettacoli-performance coordinati da Giulia Filacanapa e Georges Gagneré; concezione della piattaforma di direzione degli avatar (AKeNe): Cédric Plessiet; programmazione digitale: Georges Gagneré; artista 3D: Rémy Sohier.

[32] Il sistema MoCap Perception Neuron, una rete neurale con trentadue marcatori collocati nei punti nodali del corpo attraverso un sistema di bande elastiche, è stato collegato a una piattaforma digitale creata ad hoc dall’équipe di ricerca del laboratorio INRéV – Images Numériques et Réalité Virtuelle dell’Université Paris 8. La piattaforma è basata sul motore grafico per videogiochi Unreal Engine, ed è stata progettata per visualizzare in tempo reale l’anteprima delle animazioni digitali.

[33] Agamemnon Redux. Une experience de masque et de mocap en trois scenes, di Andy Lavender da Agamennone di Eschilo. Regia di Andy Lavender, con Alexandra Beraldin e Cécile Roqué-Alsina.

[34] Cfr. A. Lavender, Performance in the Twenty-First Century: Theatres of Engagement, London-New York, Routledge, 2016.

[35] La vie en rose. De la clinique à l’éternité, di Boris Dymny e Giulia Filacanapa. Regia di Giulia Filacanapa, maschere di Stefano Perocco di Meduna, con Ethel de Sousa, Boris Dymny, Léandre Ruiz, Morgane Lombardi.

[36] La psychanalyse augmentée, di Mathieu Milesi. Progetto e regia di Duccio Bellugi e Mathieu Milesi, con Medhi Benabbas, Assya Benhaddou, Cécilia Clarisse, Mariam Dimitri, Léa Jourdain, Béni Kianda-Petevo, Anastasiia Ternova, Ioana Voicu.